-Kode instruksi diatas menginstall versi ringan dari 🤗 Transformers. Versi ringan ini tidak mengistall modul _machine learning_ (seperti PyTorch atau TensorFlow). Sangat direkomendasikan untuk mengistal versi _development_ dari modul ini karena nanti anda akan menggunakan berbagai macam fitur yang tersedia didalam modul ini dan versi ini juga akan mencakup berbagai macam modul untuk segala macam kasus yang akan dihadapi dalam kursus ini. Untuk mengistal versi _development_, silahkan eksekusi kode dibawah:

+Perintah di atas menginstal versi ringan dari 🤗 Transformers, tanpa pustaka _machine learning_ seperti PyTorch atau TensorFlow. Karena dalam kursus ini Anda akan menggunakan berbagai fitur tambahan, sangat disarankan untuk menginstal versi _development_ yang lebih lengkap dengan perintah berikut:

```

!pip install transformers[sentencepiece]

```

-Proses instalasi akan berlangsung cukup lama. Tapi saat instalasi selesai, anda sudah siap untuk menyelesaikan kursus ini!

+Proses instalasi mungkin akan memakan waktu beberapa menit. Setelah selesai, Anda siap melanjutkan kursus ini!

-## Menggunakan Python _virtual environment_

+## Menggunakan Python _Virtual Environment_[[using-a-python-virtual-environment]]

-Jika anda ingin menggunakan Python _virtual environment_, tentu saja langkah pertama yang harus anda lewati adalah menginstal Python. Untuk menginstal Python, bisa mengikuti referensi di tautan [ini](https://realpython.com/installing-python/).

+Jika Anda memilih untuk menggunakan _virtual environment_, langkah pertama adalah menginstal Python. Panduan instalasi dapat ditemukan di tautan berikut: [https://realpython.com/installing-python/](https://realpython.com/installing-python/).

-Setelah Python berhasil terinstalasi, anda bisa menjalankan kode Python di terminal anda. Anda bisa memulai dengan mengeksekusi instruksi berikut untuk memastikan bahwa Python terinstalasi dengan benar: `python --version`. Instruksi ini akan menampilkan versi Python yang terinstalasi di komputer anda.

+Setelah Python berhasil diinstal, jalankan perintah berikut di terminal untuk memastikan bahwa Python telah terpasang dengan benar:

-Python yang saat ini terinstalasi di sistem anda adalah versi Python *"utama"* untuk sistem anda. Sangat direkomendasikan untuk tidak mengotak-ngatik Python "utama" di sistem anda, dan untuk setiap aplikasi yang akan dikembangkan menggunakan Python akan lebih baik jika menggunakan versi Python berbeda. Pada umumnya, versi Python yang digunakan untuk pengembangan aplikasi bukanlah versi "utama". Ini dilakukan karena setiap aplikasi menggunakan modul yang berbeda-beda dan setiap modul memiliki ketergantugan satu sama lain. Dengan menggunakan versi berbeda, kekhawatiran terjadinya konflik antar modul dapat dihindari.

+```

+python --version

+```

-Penggunaan versi berbeda dari Python dilakukan dengan menggunakan [*virtual environments*](https://docs.python.org/3/tutorial/venv.html). _Virtual environment_ adalah instalasi Python terpisah yang digunakan untuk keperluan tertentu aplikasi. Di dalam virtual environment, versi Python maupun modul-modul yang terinstal akan terisolasi dari versi Python "utama". Terdapata banyak cara untuk membuat _virtual environment_, tapi di kursus ini kita akan mengikuti arahan khusus dari dokumentasi resmi Python yang dinamai [`venv`](https://docs.python.org/3/library/venv.html#module-venv).

+Perintah tersebut akan menampilkan versi Python yang digunakan sistem Anda. Python bawaan sistem disebut sebagai versi *utama*, dan sebaiknya tidak diubah. Untuk setiap proyek pengembangan, disarankan menggunakan versi Python terpisah, karena setiap proyek umumnya memerlukan dependensi yang berbeda. Hal ini bertujuan untuk menghindari konflik antar modul.

-Pertama, buatlah folder baru untuk menyimpan aplikasi yang akan dibuat. Sebagai contoh, anda mungkin akan membuat folder baru bernama *transformers-course* di root folder dari home directory komputer anda:

+Solusi terbaik adalah dengan menggunakan [_virtual environment_](https://docs.python.org/3/tutorial/venv.html), yaitu instalasi Python terisolasi yang hanya digunakan untuk satu proyek tertentu. Dalam kursus ini, kita akan menggunakan modul bawaan Python, yaitu [`venv`](https://docs.python.org/3/library/venv.html#module-venv), untuk membuatnya.

+

+Pertama, buat folder baru untuk menyimpan proyek Anda. Misalnya:

```

mkdir ~/transformers-course

cd ~/transformers-course

```

-Setelah masuk ke folder baru tersebut, buatlah _virtual environment_ menggunakan modul `venv` Python:

+Kemudian buat _virtual environment_:

```

python -m venv .env

```

-Setelah menggunakan modul `venv`, anda akan memiliki folder baru bernama *.env*:

+Setelah dijalankan, akan muncul folder baru bernama `.env`:

```

ls -a

@@ -79,7 +83,7 @@ ls -a

. .. .env

```

-Instruksi dibawah adalah instruksi untuk mengaktifkan dan menonaktifkan _virtual environment_ yang baru saja dibuat:

+Berikut ini perintah untuk mengaktifkan dan menonaktifkan _virtual environment_:

```

# Mengaktifkan virtual environment

@@ -89,22 +93,24 @@ source .env/bin/activate

deactivate

```

-Anda bisa memastikan bahwa anda menggunakan Python versi _virtual environment_ dengan mengeksekusi `which python` di terminal: jika balasan terminal adalah Python di dalam folder *.env*, maka _virtual environment_ anda sudah aktif!

+Untuk memastikan Anda menggunakan versi Python dari _virtual environment_, jalankan:

```

which python

```

+Jika hasilnya menunjuk ke folder `.env`, maka _virtual environment_ Anda sudah aktif:

+

```out

/home/

-Kode instruksi diatas menginstall versi ringan dari 🤗 Transformers. Versi ringan ini tidak mengistall modul _machine learning_ (seperti PyTorch atau TensorFlow). Sangat direkomendasikan untuk mengistal versi _development_ dari modul ini karena nanti anda akan menggunakan berbagai macam fitur yang tersedia didalam modul ini dan versi ini juga akan mencakup berbagai macam modul untuk segala macam kasus yang akan dihadapi dalam kursus ini. Untuk mengistal versi _development_, silahkan eksekusi kode dibawah:

+Perintah di atas menginstal versi ringan dari 🤗 Transformers, tanpa pustaka _machine learning_ seperti PyTorch atau TensorFlow. Karena dalam kursus ini Anda akan menggunakan berbagai fitur tambahan, sangat disarankan untuk menginstal versi _development_ yang lebih lengkap dengan perintah berikut:

```

!pip install transformers[sentencepiece]

```

-Proses instalasi akan berlangsung cukup lama. Tapi saat instalasi selesai, anda sudah siap untuk menyelesaikan kursus ini!

+Proses instalasi mungkin akan memakan waktu beberapa menit. Setelah selesai, Anda siap melanjutkan kursus ini!

-## Menggunakan Python _virtual environment_

+## Menggunakan Python _Virtual Environment_[[using-a-python-virtual-environment]]

-Jika anda ingin menggunakan Python _virtual environment_, tentu saja langkah pertama yang harus anda lewati adalah menginstal Python. Untuk menginstal Python, bisa mengikuti referensi di tautan [ini](https://realpython.com/installing-python/).

+Jika Anda memilih untuk menggunakan _virtual environment_, langkah pertama adalah menginstal Python. Panduan instalasi dapat ditemukan di tautan berikut: [https://realpython.com/installing-python/](https://realpython.com/installing-python/).

-Setelah Python berhasil terinstalasi, anda bisa menjalankan kode Python di terminal anda. Anda bisa memulai dengan mengeksekusi instruksi berikut untuk memastikan bahwa Python terinstalasi dengan benar: `python --version`. Instruksi ini akan menampilkan versi Python yang terinstalasi di komputer anda.

+Setelah Python berhasil diinstal, jalankan perintah berikut di terminal untuk memastikan bahwa Python telah terpasang dengan benar:

-Python yang saat ini terinstalasi di sistem anda adalah versi Python *"utama"* untuk sistem anda. Sangat direkomendasikan untuk tidak mengotak-ngatik Python "utama" di sistem anda, dan untuk setiap aplikasi yang akan dikembangkan menggunakan Python akan lebih baik jika menggunakan versi Python berbeda. Pada umumnya, versi Python yang digunakan untuk pengembangan aplikasi bukanlah versi "utama". Ini dilakukan karena setiap aplikasi menggunakan modul yang berbeda-beda dan setiap modul memiliki ketergantugan satu sama lain. Dengan menggunakan versi berbeda, kekhawatiran terjadinya konflik antar modul dapat dihindari.

+```

+python --version

+```

-Penggunaan versi berbeda dari Python dilakukan dengan menggunakan [*virtual environments*](https://docs.python.org/3/tutorial/venv.html). _Virtual environment_ adalah instalasi Python terpisah yang digunakan untuk keperluan tertentu aplikasi. Di dalam virtual environment, versi Python maupun modul-modul yang terinstal akan terisolasi dari versi Python "utama". Terdapata banyak cara untuk membuat _virtual environment_, tapi di kursus ini kita akan mengikuti arahan khusus dari dokumentasi resmi Python yang dinamai [`venv`](https://docs.python.org/3/library/venv.html#module-venv).

+Perintah tersebut akan menampilkan versi Python yang digunakan sistem Anda. Python bawaan sistem disebut sebagai versi *utama*, dan sebaiknya tidak diubah. Untuk setiap proyek pengembangan, disarankan menggunakan versi Python terpisah, karena setiap proyek umumnya memerlukan dependensi yang berbeda. Hal ini bertujuan untuk menghindari konflik antar modul.

-Pertama, buatlah folder baru untuk menyimpan aplikasi yang akan dibuat. Sebagai contoh, anda mungkin akan membuat folder baru bernama *transformers-course* di root folder dari home directory komputer anda:

+Solusi terbaik adalah dengan menggunakan [_virtual environment_](https://docs.python.org/3/tutorial/venv.html), yaitu instalasi Python terisolasi yang hanya digunakan untuk satu proyek tertentu. Dalam kursus ini, kita akan menggunakan modul bawaan Python, yaitu [`venv`](https://docs.python.org/3/library/venv.html#module-venv), untuk membuatnya.

+

+Pertama, buat folder baru untuk menyimpan proyek Anda. Misalnya:

```

mkdir ~/transformers-course

cd ~/transformers-course

```

-Setelah masuk ke folder baru tersebut, buatlah _virtual environment_ menggunakan modul `venv` Python:

+Kemudian buat _virtual environment_:

```

python -m venv .env

```

-Setelah menggunakan modul `venv`, anda akan memiliki folder baru bernama *.env*:

+Setelah dijalankan, akan muncul folder baru bernama `.env`:

```

ls -a

@@ -79,7 +83,7 @@ ls -a

. .. .env

```

-Instruksi dibawah adalah instruksi untuk mengaktifkan dan menonaktifkan _virtual environment_ yang baru saja dibuat:

+Berikut ini perintah untuk mengaktifkan dan menonaktifkan _virtual environment_:

```

# Mengaktifkan virtual environment

@@ -89,22 +93,24 @@ source .env/bin/activate

deactivate

```

-Anda bisa memastikan bahwa anda menggunakan Python versi _virtual environment_ dengan mengeksekusi `which python` di terminal: jika balasan terminal adalah Python di dalam folder *.env*, maka _virtual environment_ anda sudah aktif!

+Untuk memastikan Anda menggunakan versi Python dari _virtual environment_, jalankan:

```

which python

```

+Jika hasilnya menunjuk ke folder `.env`, maka _virtual environment_ Anda sudah aktif:

+

```out

/home/ +

+- **Di mana saya bisa mendapatkan kode kursus?**

+ Klik banner di atas bagian kursus untuk menjalankan notebook di Google Colab atau Amazon SageMaker Studio Lab.

+

+

+

+- **Di mana saya bisa mendapatkan kode kursus?**

+ Klik banner di atas bagian kursus untuk menjalankan notebook di Google Colab atau Amazon SageMaker Studio Lab.

+

+  -Syarat mengikuti kursus:

+ Semua notebook juga tersedia di repo [`huggingface/notebooks`](https://github.com/huggingface/notebooks). Untuk menjalankan secara lokal, lihat panduan di repo [`course`](https://github.com/huggingface/course#-jupyter-notebooks).

-* Requires a good knowledge of Python

-* Pengetahuan mengenai Python

-* Akan lebih baik jika sudah mengenal deep learning dengan mengambil kursus dari [fast.ai](https://www.fast.ai/) "[Practical Deep Learning for Coders](https://course.fast.ai/)" atau program-program yang dikembangkan oleh [DeepLearning.AI](https://www.deeplearning.ai/)

-* Tidak perlu pengetahuan mengenai [PyTorch](https://pytorch.org/) atau [TensorFlow](https://www.tensorflow.org/). Tapi, akan lebih baik jika sudah terbiasa dengan salah satu framework tersebut.

+- **Bagaimana saya bisa berkontribusi?**

+ Temukan typo atau bug? Buat issue di repo [`course`](https://github.com/huggingface/course). Ingin bantu menerjemahkan kursus ini? Ikuti panduan [di sini](https://github.com/huggingface/course#translating-the-course-into-your-language).

-Setelah menyelesaikan kursus ini, sangat direkomendasikan untuk mengikuti kursus dari DeepLearning.AI [Natural Language Processing Specialization](https://www.coursera.org/specializations/natural-language-processing?utm_source=deeplearning-ai&utm_medium=institutions&utm_campaign=20211011-nlp-2-hugging_face-page-nlp-refresh) yang akan mencakup model-model NLP klasik seperti naive Bayes dan LSTM. Pengetahuan tersebut akan sangat berharga bagi anda!

+- **Apa saja pertimbangan dalam terjemahan?**

+ Setiap terjemahan memiliki glosarium dan file `TRANSLATING.txt` yang mendokumentasikan pilihan istilah teknis. Contoh: [bahasa Jerman](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

-## Tentang penulis

+- **Bisakah saya menggunakan ulang materi ini?**

+ Tentu! Kursus ini dirilis di bawah lisensi [Apache 2](https://www.apache.org/licenses/LICENSE-2.0.html). Berikan atribusi yang sesuai dan tautan ke lisensi. Bila ingin mengutip, gunakan BibTeX berikut:

-**Abubakar Abid** adalah lulusan PhD dari Stanford dengan konsentrasi aplikasi pembelajaran mesin. Sembari menyelesaikan pendidikan PhD, beliau menciptakan [Gradio](https://github.com/gradio-app/gradio), sebuah modul _open-source_ Python yang sudah digunakan untuk membuat lebih dari 600.000 demo (prototype) model _machine learning_. Gradio telah diakusisi oleh Hugging Face, tempat dimana Abubakar bekerja sebagai _machine learning team lead_.

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed

-Syarat mengikuti kursus:

+ Semua notebook juga tersedia di repo [`huggingface/notebooks`](https://github.com/huggingface/notebooks). Untuk menjalankan secara lokal, lihat panduan di repo [`course`](https://github.com/huggingface/course#-jupyter-notebooks).

-* Requires a good knowledge of Python

-* Pengetahuan mengenai Python

-* Akan lebih baik jika sudah mengenal deep learning dengan mengambil kursus dari [fast.ai](https://www.fast.ai/) "[Practical Deep Learning for Coders](https://course.fast.ai/)" atau program-program yang dikembangkan oleh [DeepLearning.AI](https://www.deeplearning.ai/)

-* Tidak perlu pengetahuan mengenai [PyTorch](https://pytorch.org/) atau [TensorFlow](https://www.tensorflow.org/). Tapi, akan lebih baik jika sudah terbiasa dengan salah satu framework tersebut.

+- **Bagaimana saya bisa berkontribusi?**

+ Temukan typo atau bug? Buat issue di repo [`course`](https://github.com/huggingface/course). Ingin bantu menerjemahkan kursus ini? Ikuti panduan [di sini](https://github.com/huggingface/course#translating-the-course-into-your-language).

-Setelah menyelesaikan kursus ini, sangat direkomendasikan untuk mengikuti kursus dari DeepLearning.AI [Natural Language Processing Specialization](https://www.coursera.org/specializations/natural-language-processing?utm_source=deeplearning-ai&utm_medium=institutions&utm_campaign=20211011-nlp-2-hugging_face-page-nlp-refresh) yang akan mencakup model-model NLP klasik seperti naive Bayes dan LSTM. Pengetahuan tersebut akan sangat berharga bagi anda!

+- **Apa saja pertimbangan dalam terjemahan?**

+ Setiap terjemahan memiliki glosarium dan file `TRANSLATING.txt` yang mendokumentasikan pilihan istilah teknis. Contoh: [bahasa Jerman](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

-## Tentang penulis

+- **Bisakah saya menggunakan ulang materi ini?**

+ Tentu! Kursus ini dirilis di bawah lisensi [Apache 2](https://www.apache.org/licenses/LICENSE-2.0.html). Berikan atribusi yang sesuai dan tautan ke lisensi. Bila ingin mengutip, gunakan BibTeX berikut:

-**Abubakar Abid** adalah lulusan PhD dari Stanford dengan konsentrasi aplikasi pembelajaran mesin. Sembari menyelesaikan pendidikan PhD, beliau menciptakan [Gradio](https://github.com/gradio-app/gradio), sebuah modul _open-source_ Python yang sudah digunakan untuk membuat lebih dari 600.000 demo (prototype) model _machine learning_. Gradio telah diakusisi oleh Hugging Face, tempat dimana Abubakar bekerja sebagai _machine learning team lead_.

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed  -**Lucile Saulnier** adalah _machine learning engineer_ di Hugging Face, bertugas untuk mengembangkan dan mendukung penggunaan alat-alat _open source_. Beliau juga aktif dalam banyak riset mengenai _Natural Language Processing_ seperti _collaborative training_ dan BigScience.

+

-**Lucile Saulnier** adalah _machine learning engineer_ di Hugging Face, bertugas untuk mengembangkan dan mendukung penggunaan alat-alat _open source_. Beliau juga aktif dalam banyak riset mengenai _Natural Language Processing_ seperti _collaborative training_ dan BigScience.

+ +

+ +

+ +

+ +

+ +

+ +

+text-generation."

+ },

+ {

+ text: "Mengembalikan kata-kata yang mewakili orang, organisasi, atau lokasi.",

+ explain: "Benar! Dengan grouped_entities=True, entitas seperti \"Hugging Face\" akan dikelompokkan sebagai satu entitas.",

+ correct: true

+ }

+ ]}

+/>

+

+### 3. Apa yang seharusnya menggantikan `...` dalam contoh kode berikut?

+

+```python

+from transformers import pipeline

+

+filler = pipeline("fill-mask", model="bert-base-cased")

+result = filler("...")

+```

+

+bert-base-cased."

+ },

+ {

+ text: "This [MASK] has been waiting for you.",

+ explain: "Benar! Token masker untuk model ini adalah [MASK].",

+ correct: true

+ },

+ {

+ text: "This man has been waiting for you.",

+ explain: "Salah. Pipeline ini memerlukan token mask dalam input."

+ }

+ ]}

+/>

+

+### 4. Mengapa kode berikut gagal dijalankan?

+

+```python

+from transformers import pipeline

+

+classifier = pipeline("zero-shot-classification")

+result = classifier("This is a course about the Transformers library")

+```

+

+processing_class dalam Trainer?

+

+fp16=True dalam TrainingArguments?

+

+compute_metrics dalam Trainer?

+

+eval_dataset ke Trainer?

+

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

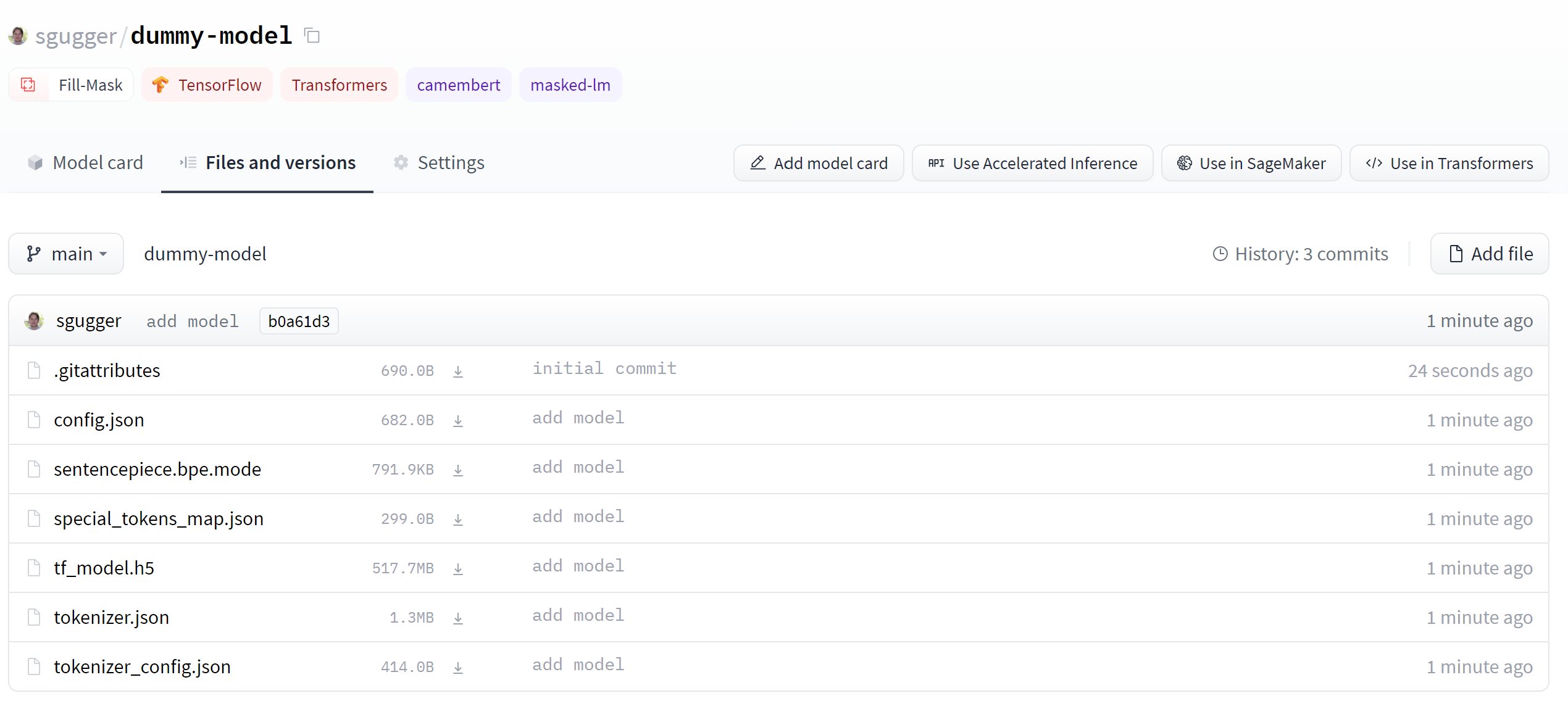

+push_to_hub. Apa lagi yang bisa Anda unggah?",

+ correct: true

+ },

+ {

+ text: "Model",

+ explain: "Benar! Semua model bisa diunggah bersama file konfigurasi mereka. Tapi ini juga bukan satu-satunya.",

+ correct: true

+ },

+ {

+ text: "Trainer",

+ explain: "Betul — Trainer juga memiliki metode push_to_hub, yang akan mengunggah model, konfigurasi, tokenizer, dan draft model card.",

+ correct: true

+ }

+ ]}

+/>

+{:else}

+push_to_hub. Apa lagi yang bisa Anda unggah?",

+ correct: true

+ },

+ {

+ text: "Model",

+ explain: "Benar! Semua model bisa diunggah bersama file konfigurasi mereka. Tapi ini juga bukan satu-satunya.",

+ correct: true

+ },

+ {

+ text: "Semua di atas menggunakan callback khusus",

+ explain: "Benar — PushToHubCallback akan secara berkala mengunggah semuanya ke repositori selama pelatihan.",

+ correct: true

+ }

+ ]}

+/>

+{/if}

+

+### 6. Apa langkah pertama saat menggunakan metode `push_to_hub()` atau alat CLI?

+

+huggingface_hub — tidak perlu dibungkus lagi!"

+ },

+ {

+ text: "Dengan menyimpannya ke disk dan menjalankan transformers-cli upload-model",

+ explain: "Perintah upload-model tidak ada."

+ }

+ ]}

+/>

+

+### 8. Operasi git apa saja yang bisa Anda lakukan dengan kelas `Repository`?

+

+git_pull().",

+ correct: true

+ },

+ {

+ text: "Push",

+ explain: "Metode git_push() digunakan untuk itu.",

+ correct: true

+ },

+ {

+ text: "Merge",

+ explain: "Tidak, operasi ini tidak akan tersedia melalui API ini."

+ }

+ ]}

+/>

diff --git a/chapters/id/chapter5/1.mdx b/chapters/id/chapter5/1.mdx

new file mode 100644

index 000000000..6708224a5

--- /dev/null

+++ b/chapters/id/chapter5/1.mdx

@@ -0,0 +1,22 @@

+# Pendahuluan[[introduction]]

+

+| + | patient_id | +drugName | +condition | +review | +rating | +date | +usefulCount | +review_length | +

|---|---|---|---|---|---|---|---|---|

| 0 | +95260 | +Guanfacine | +adhd | +"My son is halfway through his fourth week of Intuniv..." | +8.0 | +April 27, 2010 | +192 | +141 | +

| 1 | +92703 | +Lybrel | +birth control | +"I used to take another oral contraceptive, which had 21 pill cycle, and was very happy- very light periods, max 5 days, no other side effects..." | +5.0 | +December 14, 2009 | +17 | +134 | +

| 2 | +138000 | +Ortho Evra | +birth control | +"This is my first time using any form of birth control..." | +8.0 | +November 3, 2015 | +10 | +89 | +

| + | condition | +frequency | +

|---|---|---|

| 0 | +birth control | +27655 | +

| 1 | +depression | +8023 | +

| 2 | +acne | +5209 | +

| 3 | +anxiety | +4991 | +

| 4 | +pain | +4744 | +

+

+ +

+ +

+ +

+ +

+| + | html_url | +title | +comments | +body | +

|---|---|---|---|---|

| 0 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +kode bug terletak di:\r\n if data_args.task_name is not None... | +Halo,\r\nSaya mencoba menjalankan run_glue.py dan mendapatkan error berikut... | +

| 1 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +Hai @jinec,\r\n\r\nSesekali kami mendapat `ConnectionError` seperti ini dari situs github.com: https://raw.githubusercontent.com... | +Halo,\r\nSaya mencoba menjalankan run_glue.py dan mendapatkan error berikut... | +

| 2 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +tidak bisa konek, bahkan lewat browser, tolong dicek apakah ada masalah. | +Halo,\r\nSaya mencoba menjalankan run_glue.py dan mendapatkan error berikut... | +

| 3 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +Saya bisa mengakses https://raw.githubusercontent.com/huggingface/datasets/1.7.0/datasets/glue/glue.py tanpa masalah... | +Halo,\r\nSaya mencoba menjalankan run_glue.py dan mendapatkan error berikut... | +

load_dataset() untuk memuat dataset lokal.",

+ correct: true

+ },

+ {

+ text: "Dari Hugging Face Hub",

+ explain: "Benar! Anda bisa memuat dataset dari Hub dengan memberikan ID dataset, misalnya load_dataset('emotion').",

+ correct: true

+ },

+ {

+ text: "Dari server jarak jauh",

+ explain: "Benar! Anda bisa memberikan URL ke argumen data_files pada load_dataset() untuk memuat file dari server jarak jauh.",

+ correct: true

+ },

+ ]}

+/>

+

+### 2. Misalkan Anda memuat salah satu tugas GLUE sebagai berikut:

+

+```py

+from datasets import load_dataset

+

+dataset = load_dataset("glue", "mrpc", split="train")

+```

+

+Perintah mana yang akan menghasilkan sampel acak sebanyak 50 elemen dari `dataset`?

+

+Dataset.sample()."

+ },

+ {

+ text: "dataset.shuffle().select(range(50))",

+ explain: "Benar! Seperti yang Anda lihat di bab ini, Anda harus mengacak dataset terlebih dahulu dan kemudian memilih sampel darinya.",

+ correct: true

+ },

+ {

+ text: "dataset.select(range(50)).shuffle()",

+ explain: "Ini salah -- meskipun kodenya akan berjalan, itu hanya akan mengacak 50 elemen pertama dari dataset."

+ }

+ ]}

+/>

+

+### 3. Misalkan Anda memiliki dataset tentang hewan peliharaan bernama `pets_dataset`, yang memiliki kolom `name` yang menunjukkan nama setiap hewan. Pendekatan mana yang akan memungkinkan Anda menyaring dataset untuk semua hewan peliharaan yang namanya dimulai dengan huruf "L"?

+

+pets_dataset.filter(lambda x['name'].startswith('L'))",

+ explain: "Ini salah -- fungsi lambda harus dalam bentuk umum lambda *argumen* : *ekspresi*, jadi Anda perlu memberikan argumen di sini."

+ },

+ {

+ text: "Buat fungsi seperti def filter_names(x): return x['name'].startswith('L') lalu jalankan pets_dataset.filter(filter_names).",

+ explain: "Benar! Seperti pada Dataset.map(), Anda bisa memberikan fungsi eksplisit ke Dataset.filter(). Ini berguna untuk logika kompleks yang tidak cocok dalam fungsi lambda pendek.",

+ correct: true

+ }

+ ]}

+/>

+

+### 4. Apa itu memory mapping?

+

+IterableDataset adalah generator, bukan kontainer, jadi Anda harus mengakses elemennya menggunakan next(iter(dataset)).",

+ correct: true

+ },

+ {

+ text: "Dataset allocine tidak memiliki split train.",

+ explain: "Ini salah -- lihat [kartu dataset allocine](https://huggingface.co/datasets/allocine) di Hub untuk melihat split yang tersedia."

+ }

+ ]}

+/>

+

+### 7. Apa saja manfaat utama dari membuat kartu dataset?

+

+`` and '' with " and any sequence of two or more spaces with a single space, as well as removing the accents in the texts to tokenize.

+

+The pre-tokenizer to use for any SentencePiece tokenizer is `Metaspace`:

+

+```python

+tokenizer.pre_tokenizer = pre_tokenizers.Metaspace()

+```

+

+We can have a look at the pre-tokenization of an example text like before:

+

+```python

+tokenizer.pre_tokenizer.pre_tokenize_str("Let's test the pre-tokenizer!")

+```

+

+```python out

+[("▁Let's", (0, 5)), ('▁test', (5, 10)), ('▁the', (10, 14)), ('▁pre-tokenizer!', (14, 29))]

+```

+

+Next is the model, which needs training. XLNet has quite a few special tokens:

+

+```python

+special_tokens = ["